1. Un médium

Nous manipulons les symboles par leurs parties signifiantes. Le signifiant fonctionne comme la poignée sensible du signifié intelligible. Les médias interviennent précisément en ce point : ce sont les machines-outils que nous utilisons pour inscrire, conserver, afficher et mobiliser les signifiants. Ils prennent en charge le support et le mouvement des messages.

Le premier médium est le corps humain vivant : attitudes, gestes, danses, chants, paroles, tatouages, masques, coiffures, vêtements… Les premiers moteurs symboliques sont nos organes : langue, main, jambe… Tous les autres médias transfèrent les opérations symboliques initialement accomplies par l’organisme humain vers des supports et des agents externes. Du côté du support, une armée de messagers s’offre à la vue : dessins, fétiches, totems, bijoux, sceaux, rouleaux, tablettes, cahiers, livres, écrans… ou à l’oreille : souffles, voix, vents, tablas, tambours, corne, trompettes, guitares, haut-parleurs, téléphone, radio… Du côté du mouvement, les médias prolongent l’action du corps pour informer la matière : marteaux, couteaux, pinceaux, plumes, crayons, claviers, baguettes, archets… Finalement les messages sont mus par des agencements techniques complexes : la poste ou le téléphone les transmettent, l’imprimerie les duplique, la radio les diffuse et les ordinateurs les transforment. À la question ontologique « qu’est-ce que le numérique ? », je réponds donc résolument : c’est un médium. Je vais parler de médium algorithmique, plutôt que numérique, parce que son principal caractère est de calculer automatiquement sur les symboles – ou d’industrialiser leur transformation – en plus de les enregistrer, de les dupliquer et de les diffuser comme le faisaient les médias antérieurs.

Les inventions de l’écriture, de l’imprimerie et des médias électroniques ont augmenté de manière irréversible nos capacités de mémoire et de communication. Ce processus s’accélère avec le numérique. Le sensorium lié au médium algorithmique est encore en émergence, mais nous savons déjà qu’il comprendra des éléments de réalité virtuelle, de réalité augmentée, de géolocalisation, de jeux collaboratifs trans-médias, de nouvelles façons de mettre en scène les relations entre les énoncés, les données, les personnes et les communautés. Avec l’émergence du médium algorithmique, nous sommes engagés dans une nouvelle étape de l’évolution culturelle.

Après avoir évoqué les fondations intellectuelles de l’informatique à l’époque moderne, je voudrais dans cet article retracer les grandes étapes de la croissance du médium algorithmique telle que nous pouvons l’appréhender en 2017 et évoquer pour finir un de ses avenirs possibles.

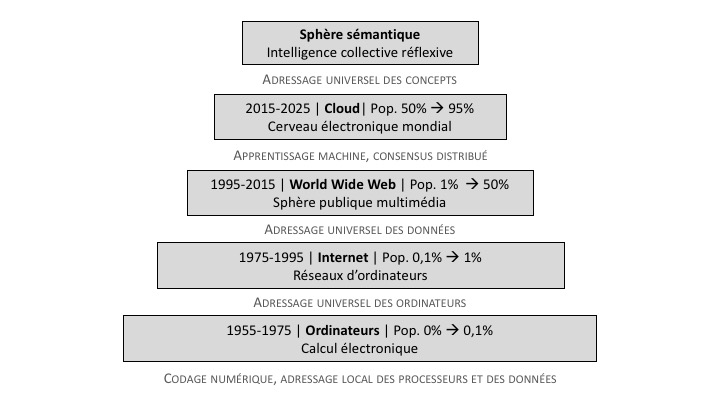

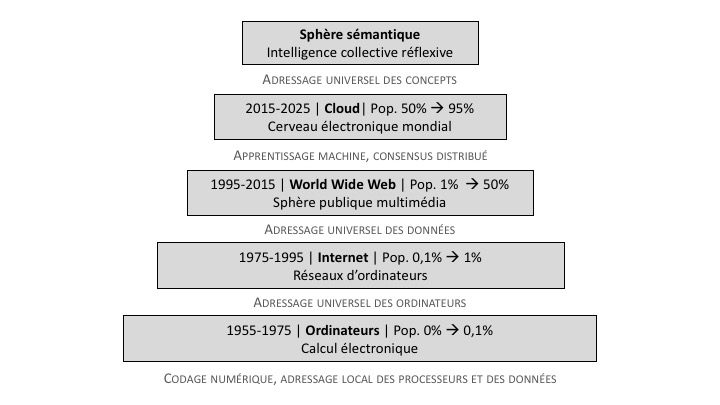

Pendant les années 1955-1975, les premiers ordinateurs ne concernaient que moins d’un pour cent de la population mondiale.

Entre 1975 et 1995, les ordinateurs personnels et l’Internet mobilisent les jeunes urbains créatifs des pays riches : un peu plus d’un pourcent de la population.

L’époque du Web (1995-2015) aboutit à la naissance d’une nouvelle sphère publique mondiale multimédia et au branchement de 50% de la population mondiale.

L’ère du Cloud (à partir de 2015) connecte la quasi-totalité de l’humanité à un cerveau global qui simule des réseaux neuronaux (apprentissage machine, intelligence artificielle) et enregistre les actes sociaux (chaîne de blocs, algorithmes de consensus distribué).

Enfin l’étape hypothétique de la Sphère sémantique favorise l’intelligence collective réflexive.

2. Les fondations

Les fondations intellectuelles de l’informatique s’étendent jusqu’aux arts de la mémoire, elles comprennent la formalisation de la logique par Aristote, la notation des nombres par position chez les Indiens et les débuts de l’algèbre dans l’antiquité et au Moyen-Âge. Mais ce récit introductif commence au début des temps modernes et se termine dans les années 1950, qui voient apparaître les premiers ordinateurs. Durant cette période, l’avènement du médium algorithmique est préparé par deux grandes tendances évolutives : le triomphe intellectuel et pratique du mécanisme entre les XVIe et XXe siècles et le travail des philosophes mathématiciens modernes qui se sont efforcés de formaliser les opérations intellectuelles. Finalement, rien ne serait arrivé sans l’effort d’ingénierie qui a mené à la construction des premiers ordinateurs entre 1930 et 1950.

2.1 Le triomphe du mécanisme

Astronomie, physique, chimie, géologie, biologie, la science moderne représente ses objets comme des mécanismes fonctionnels. Du fait de ses liens théoriques et pratiques avec les machines, la science est impliquée dans le développement technique et donc dans les sphères économique et militaire. Après la Seconde Guerre mondiale, le terme de techno-science est inventé pour souligner la liaison de plus en plus étroite entre les deux domaines. La conception du mécanisme évolue entre le XVIe et le XXe siècle en suivant l’évolution des machines. Trois types se succèdent : l’horloge, le moteur, l’ordinateur.

Jusqu’au XVIIIe siècle, les machines-modèles sont les horloges, dont les artisans européens ont une grande maîtrise depuis le XIIIe siècle. En ces temps reculés, la force humaine, animale, aérienne, hydrolique entraîne des machines faites de bois et de métal. C’est l’âge des bateaux à voiles, des moulins à eau et à vent. Leviers, ressorts, poulies et balanciers entretiennent et démultiplient les mouvements. Des arbres et des roues dentées transmettent les forces et changent leurs angles d’application. Ce mécanisme traduit un genre de mouvement dans un autre. Il correspond à la physique de Galilée, de Descartes et de Newton. A partir de Newton, le mécanisme devient plus subtil. Il ne se définit plus par contacts et poussées entre objets matériels, mais par des principes abstraits : égalité de l’action et de la réaction, conservation de l’énergie, principe de moindre action. Il suffit qu’une relation entre grandeurs soit exprimée par une fonction mathématique calculable et qu’une « loi » conserve certaines symétries fondamentales pour que l’exigence mécaniste soit satisfaite.

Dès le début du XIXe siècle, les machines de référence deviennent les moteurs et la physique accueille une nouvelle discipline : la thermodynamique. Le mécanisme classique perdure et se perfectionne, mais il est entraîné et piloté par des moteurs. C’est l’époque des grandes usines actionnées par une machine à vapeur centrale. Des panaches de fumée s’élèvent au-dessus des chemins de fer et des bateaux. Moyennant une certaine déperdition d’énergie, les machines des XIXe et XXe siècles traduisent une forme d’énergie dans une autre. La chaleur d’une chaudière à vapeur se métamorphose en mouvement. La rotation de turbines se change en électricité et l’électricité à son tour se change en lumière. Au XXe siècle, les moteurs à explosion et à réaction équipent des voitures automobiles, des avions et des fusées. Les centrales nucléaires produisent une électricité distribuée par d’immenses réseaux à une multitude de moteurs, de lampes et d’appareils électroniques.

Dès le début des années 1950, la machine reine devient l’ordinateur. Elle ne transforme plus l’énergie mais l’information. Le mécanisme informationnel traduit un message d’entrée en message de sortie. Le frottement, la déperdition de force, l’entropie des machines thermodynamiques se transforment en bruit (au sens de la théorie de l’information). Les bugs des nouvelles machines sont dus à des incohérences logiques. Les moteurs existent encore – ils se multiplient et s’améliorent – mais ils sont désormais contrôlés et commandés par des processeurs d’information codée. Le nouveau mécanisme hérite de l’oeuvre des philosophes qui se sont appliqués à mathématiser les opérations cognitives et du travail des ingénieurs qui ont implanté les opérations cognitives mathématisées dans des machines physiques.

2.2 Les philosophes mathématiciens après Descartes

Dans la connaissance scientifique de la nature qui s’est inventée à la fin de la Renaissance – époque de renouveau platonicien – ce sont les mathématiques qui représentent l’esprit, le texte caché sous-jacent aux phénomènes sensibles. Mais de manière paradoxale l’exigence de mathématisation avait exclu l’esprit des objets des sciences exactes. Et c’est pourquoi la préparation souterraine d’un retour de l’esprit dans la nature fut le fait de philosophes mathématiciens.

Blaise Pascal (1623-1662) qui a introduit le pari en théologie, a aussi initié le calcul des probabilités. Ce faisant, il mathématise une partie du raisonnement inductif. Ce fut également l’inventeur de l’une des premières machines à faire les additions: une autre opération mentale est mécanisée ? Leibniz (1646-1716) a mis au point une machine effectuant les additions et les multiplications, formalise la combinatoire – conçue comme une méthode d’invention – et cherche à ramener les raisonnements à un calcul. Georges Boole (1815-1864) est le premier à ramener effectivement le raisonnement logique à une algèbre qui est aujourd’hui encore à la base des circuits électroniques et des algorithmes. Bien qu’il soit généralement considéré comme un mathématicien, il se voyait lui-même comme un philosophe étudiant les lois de la pensée. Georg Cantor (1845-1918) inventa la théorie des ensembles, dont une version informelle sous-tend une bonne part de nos classifications et de nos inférences quotidiennes. Il fit aussi entrer le raisonnement sur l’infini dans les mathématiques.

A partir de la fin du XIXe siècle, nombre de travaux convergent vers la formalisation logique des mathématiques et la mathématisation de la logique, domaine dans lequel s’illustrent deux philosophes mathématiciens, Bertrand Russel (1872-1970) et Alfred North Whitehead (1861-1947). Ils signent ensemble les trois tomes des Principia Mathematica (1910-1913), grandiose tentative pour éliminer les paradoxes, systématiser mathématiquement le raisonnement logique et axiomatiser l’ensemble des mathématiques. Russell et Whitehead sont par ailleurs chacun de leur côté les auteurs d’oeuvres philosophiques de plein droit, dans lesquels ils ne se sont pas privés d’aborder tous les grands problèmes.

Ludwig Wittgenstein (1889-1951) est un autre philosophe important du début du XXe siècle qui s’est tenu proche des mathématiques et de la logique formelle après des études d’ingénieur. Il est lié à Russell et à l’atomisme logique de Cambridge en Angleterre comme au mouvement du positivisme logique de Vienne, en Autriche. Il tente d’abord de ramener la connaissance à la logique : « Les pensées sont des images logiques de faits » (dans le Tractatus logico-philosophicus de 1921). Il invente au passage les tables de vérité, encore utilisées. Il met en évidence le caractère tautologique des raisonnements logiques : il n’y a rien de vraiment nouveau dans la conclusion d’un raisonnement formel. Mais quelques expériences de vie et conversations après la publication du Tractatus, il découvre la complexité, l’indétermination et la multiplicité des usages de la parole. Dans sa théorie des « jeux de langages », Wittgenstein révise de manière déchirante ses premières thèses et parle des usages de la parole comme de formes de vie. Cette théorie des jeux de langage fut publiée après sa mort dans les Investigations philosophiques (1953). Malgré la diversité de ses intérêts et la contradiction de ses positions, deux questions entrelacées courent dans son oeuvre et l’unifient : celle du rapport entre pensée et langage (« Les limites de mon langage sont les limites de mon propre monde », affirme-t-il dès le Tractatus) et celle qui porte sur les fondements et le statut des mathématiques.

Principalement connu comme philosophe, Edmund Husserl (1859-1938) était un mathématicien au commencement de sa carrière. Après une rigoureuse réflexion sur les objets mathématiques, il en vint à fonder l’école phénoménologique en philosophie, qui étudie et décrit les structures de la conscience. Il pensait d’ailleurs que cette science de la conscience était impossible à mathématiser et qu’elle représentait même le non-mathématisable par excellence, l’autre de la science mathématique de la nature. Husserl s’inspira de la démarche cartésienne, qui faisait reposer la connaissance sur la conscience réflexive : l’un de ses fameux ouvrages porte précisément le titre de Méditations cartésiennes (1931). Husserl fut lié à David Hilbert – un des plus grands mathématiciens du début du XXe siècle – alors qu’ils étaient ensemble professeurs à l’Université de Gottingen pendant les années 19101.

L’oeuvre de David Hilbert (1862-1943) est particulièrement importante pour notre propos. Il travaille à systématiser l’algèbre et met au premier plan l’étude formelle des relations et des opérations – ce que l’on appellera plus tard les structures, par opposition avec la nature particulière des objets sur lesquels portent les opérations et relations2. C’est ainsi que des univers qui semblent fort éloignés l’un de l’autre (comme, par exemple, ceux des figures géométriques et des nombres) s’avèrent posséder des structures mathématiques communes. De grands noms américains de la théorie des automates et du calcul étudièrent auprès de Hilbert à l’Université de Göttingen, tels John von Neuman (1903-1957) et Alonzo Church (1903-1995) qui contribuent à la théorie de la calculabilité.

Les problèmes posés par Hilbert inspirent les travaux de Gödel (1906-1978) et de Turing (1912-1954), qui comptent parmi les fondateurs du nouveau mécanisme informatique. Gödel démontre qu’une théorie mathématique suffisamment complexe pour décrire l’arithmétique est incapable de décider de la vérité de tous ses théorèmes. Turing donne un modèle général de la machine à calculer et démontre grâce à sa machine universelle abstraite qu’il existe des fonctions incalculables. Dans son fameux article de 1937, il introduit pour la première fois le concept de machine universelle, c’est-à-dire le schéma formel d’un ordinateur (Turing 1937). La machine comprend deux parties : une mémoire et une tête de lecture et d’écriture. La mémoire elle-même se divise en deux parties, celle qui enregistre les opérations à effectuer, ou programmes, et celle qui enregistre les objets sur lesquels portent les opérations, ou données. La tête de lecture et d’écriture exécute les opérations en fonction des données. Puisque les programmes sont dans la mémoire, ils peuvent être écrits et effacés, exactement comme les données. Programmes et données sont l’un comme l’autre des codes, des signifiants manipulés par la même tête de lecture-écriture3.

Dans la seconde moitié du XXe siècle l’idée se répand de modéliser les fonctions cognitives par des groupes de transformations4. Comment construisons-nous des objets mentaux à partir des images discontinues et partielles de la boucle sensori-motrice ? Jean Piaget (1896-1980), nous montre que l’objet invariant abstrait des images sensibles se ramène à des groupes de transformations dans des espaces-temps coordonnés : des « catégories ». Au cours de l’apprentissage, l’intelligence réflexive poursuit cette première abstraction vers des niveaux opératoires plus complexes. Piaget fait entrer le raisonnement algébrique en psychologie cognitive. Par sa théorie des langages formels, Noam Chomsky (1928-) prépare au développement des langages de programmation et au traitement automatique des langues. Levi-Strauss (1908-2009) et le courant structuraliste ramènent les narrations et les classifications qui organisent les cultures aux variables de groupes de transformation. Tout se met en place pour que les sciences humaines des siècles à venir soient mathématisées.

3. L’ordinateur

Quelques rares machines mécaniques faisant les quatre opérations arithmétiques sont construites aux XVIIe et XVIIe siècle. Au XIXe siècle les métiers à tisser Jacquard sont entraînés par des machines à vapeur et des cartes perforés commandent au dessin des tissus. En Angleterre, l’astronome et mathématicien Babbage (1791-1871), aidé par la première programmeuse Ada Lovelace (1815-1852), travaille plusieurs années sur son analytical engine – une machine à calculer mécanique adaptable à plusieurs fonctions – sans parvenir à l’achever. Au tournant des XIXe et XXe siècle, il existe déjà des machines à calculer mécaniques dans le commerce, souvent couplées à des caisses enregistreuses. La machine électro-mécanique de Hollerith (1860-1929), qui matérialise ses données sous forme de cartes perforées, est utilisée par le bureau du recensement américain à la fin du XIXe siècle et elle est ensuite reprise par IBM.

Mais les véritables ordinateurs – codés en binaire, programmables et entièrement électroniques (à base de transistors ou de micro-processeurs) – ne commencent à être construit et effectivement utilisés qu’au milieu du XXe siècle. Il s’agit d’un seuil décisif parce que l’ordinateur est plus rapide – de plusieurs ordres de grandeurs – que les machines qui comportent des organes de calcul mécanique. Poursuivant in concreto les travaux de Boole et de Turing, Shannon et Von Neumann franchissent les derniers pas. Claude Shannon met en évidence dès 1937 le parallélisme entre certains circuits électriques et les opérations de l’algèbre de Boole. On passe ainsi de la logique mathématique à des mécanismes matériels. Les travaux de Shannon servent de base à la conception des circuits électroniques des ordinateurs. John von Neumann construit les plans du premier ordinateur, esquisse une théorie générale des automates et propose une théorie mathématique des jeux. Publié au mois de juin de 1945 son « First draft of a report on the EDVAC » présente l’architecture fondamentale des ordinateurs, encore en usage aujourd’hui : une mémoire contient les données et les programmes, une unité de contrôle interprète les instructions des programmes, une unité de calcul arithmétique et logique effectue les opérations sur les données5.

Ce n’est qu’après les travaux fondateurs des ingénieurs-mathématiciens et grâce au support physique des transistors que l’ordinateur est finalement construit et devient la machine-type de la nouvelle époque. Souvenons-nous que, de Gutenberg jusqu’au milieu du XXe siècle, le principal effet technique des médias était d’enregistrer, de reproduire et de transmettre les symboles. Ainsi de l’imprimerie (journaux, magazines, livres), de l’industrie du disque, du cinéma, du téléphone, de la radio et de la télévision. Certes, il existait bien des techniques de calcul, ou de transformation automatique des symboles. Mais les calculatrices automatiques disponibles avant les ordinateurs étaient d’un usage limité à l’arithmétique. Rien ne laissait présager qu’elles s’interconnecteraient pour former le médium dominant. Le télégraphe, le téléphone et la radio avaient déjà donné de remarquables exemples de machines de communication électriques, mais sauf dans les commutateurs automatiques utilisés par les compagnies de téléphone, l’électricité n’était utilisée que pour sa vitesse de transmission, non pour son agilité opératoire. Il faudra attendre la génération du Web et du téléphone intelligent, qui fleurit entre 1995 et 2015, pour que le public commence à reconnaître le pullulement du calcul automatique comme un médium. La puissance des algorithmes ne s’actualise que sur les bases techniques de l’électricité, des télécommunications, de la maîtrise des ondes hertziennes et de l’industrie spatiale, qui assurent la diffusion universelle. Mais leur vertu propre est l’opération automatique, la transformation réglée des symboles.

Que fait un algorithme au juste ? Il décrit la marche à suivre pour traiter les données afin de résoudre une certaine classe de problèmes en un temps fini. Les ouvrages de vulgarisation décrivent souvent l’algorithme comme une « recette », une suite d’instructions qui aboutit à un résultat. Mais cela ne rend pas tout à fait justice à la complexité de l’objet et surtout ce type de vulgarisation masque les relations d’interdépendance entre l’algorithme et l’environnement concret dans lequel il s’exécute : la machine. C’est pourquoi je dois décrire ici l’architecture d’un ordinateur et préciser le rôle de ses différentes parties dans l’exécution des algorithmes. Négligeons les dispositifs d’entrée et de sortie (les interfaces) pour nous concentrer sur le noyau logique de la machine.

La mémoire est un système de cases numérotées – précisément adressées – contenant des informations codées en binaire, des 0 et des 1.

Le processeur accomplit physiquement des opérations arithmétiques et logiques sur des séquences de 0 et de 1.

L’unité de contrôle accède aux programmes contenus dans la mémoire, les décode et les exécute. Pour exécuter un programme, elle va chercher les données d’entrée, les traite au moyen du processeur et inscrit le résultat dans la mémoire.

Pour que des traitements automatiques puissent être appliqués à des données, il faut d’abord que les données en question aient été préalablement codées de manière adéquate et uniforme. Il ne s’agit pas seulement ici du codage binaire (zéro et un), mais aussi de types de codages plus spécialisés. On peut donner comme exemple le codage des nombres (en base deux, huit, dix, seize, etc.) celui des caractères d’écriture, celui des images (les pixels), celui des sons (l’échantillonnage), et ainsi de suite.

Remarquons qu’un programme prend en entrée le contenu de certaines adresses de la mémoire et va inscrire le résultat en sortie dans d’autres adresses. Il ne porte pas sur telles ou telles données particulières mais sur les données quelconques qui sont contenues par des adresses déterminées. Un ensemble de tests (si… alors…) détermine le choix des adresses où puiser les données à traiter, le choix des opérateurs et le choix des adresses où inscrire les résultats. La circulation des données s’achève lorsqu’un test a déterminé que le traitement était terminé. Dès lors, le résultat du traitement - à savoir un ensemble de données codées - se trouve à une adresse précise de la mémoire. J’ajoute que les adresses correspondent généralement à certains types de données. Par exemple, la base de données du personnel d’une entreprise est faite de fiches qui sont toutes composées de la même manière : nom, photo, date de naissance, salaire mensuel, etc. Le « nom » comprendra des séquences de caractères alphabétiques, la « photo » une image, la « date de naissance » trois nombres correspondant au jour, au mois et à l’année, etc. Supposons qu’un programme calcule pour chaque jour de l’année la liste des employés dont c’est l’anniversaire. Il prendra en entrée le fichier du personnel, identifiera les dates de naissance et produira en sortie un calendrier qui comporte, pour chaque date, les employés concernés. On voit que la structure des données d’entrée (le fichier du personnel) et celle des données de sortie (le calendrier des anniversaires) sont différentes. Bien souvent, un programme prend une certaine structure de données en entrée et génère en sortie une autre structure de données. Dès qu’il est un peu complexe, il enchaîne, boucle ou traite en parallèle plusieurs sous-programmes, si bien qu’il met en jeu de nombreuses structures de données. Or ces structures de données virtuelles se projettent nécessairement dans les « cases-mémoire » électroniques de la machine actuelle. Aucun programme ne peut fonctionner sans savoir exactement où aller chercher les données et où inscrire les résultats. Les programmes fonctionnent donc « main dans la main » avec un système d’adressage de la mémoire qui leur facilite plus ou moins la tâche. On notera que ce sont les systèmes d’exploitation des ordinateurs (par exemple : UNIX, Windows, l’OS d’Apple, etc.) qui gèrent les adresses dans la mémoire physique des ordinateurs.

L’efficacité des programmes dépend des opérations accomplies par les processeurs électroniques. Certains processeurs sont généralistes : ils peuvent accomplir toutes les tâches, mais de manière lente et répétitive, tandis que d’autres sont spécialisés dans certaines fonctions, par exemple les puces graphiques pour le traitement des images. On aura toujours avantage à ce qu’il existe une adéquation entre le codage des données, le fonctionnement des processeurs et la stratégie de résolution de problème des programmes.

Distinguons finalement entre l’algorithme et le programme. L’algorithme est un objet abstrait, virtuel. En revanche, le programme que l’on trouve dans la mémoire d’un ordinateur est une implantation particulière d’un algorithme, codé dans un certain langage de programmation. Il s’agit d’un objet concret, d’une écriture actuelle. Les premiers langages de programmation étaient proches de l’architecture des ordinateurs et s’adressaient directement à ses organes physiques. Les langages de programmation plus récents se spécialisent dans la description des opérations de « haut niveau », telles qu’elles sont conçues dans l’esprit des programmeurs. Ils ne se transforment en instructions aux organes physiques de la machine qu’après une série de traductions.

En somme, un algorithme doit être écrit dans un ou plusieurs langages de programmation pour devenir un programme implanté dans la mémoire d’un ordinateur. Le programme génère des cycles de relations dynamiques entre des structures de données qui se projettent sur les adresses-mémoires de la machine. Pour transformer les données, le programme commande un processeur, c’est-à-dire un opérateur matériel (de type électronique, optique, quantique, moléculaire…) qui manipule des jetons micro-physiques. Dans la pratique, l’algorithme dépend donc des langages de programmation dans lesquels il est écrit et des machines qui exécutent les programmes. Du côté des machines, il faut considérer particulièrement le système d’exploitation, la taille et la structure de la mémoire, enfin les opérations accomplies par le processeur électronique.

Entre 1955 et 1975, il n’existe encore que quelques ordinateurs. Les savants réalisent l’importance historique et scientifique de ces machines mais elles n’ont pas encore d’impact sur la communication sociale du fait de leurs prix élevés et de la complexité de leur utilisation. Ce sont de gros appareils pesants refermés sur eux-mêmes, dont les interfaces d’entrée et de sortie ne peuvent être actionnées que par des spécialistes. Seules les grandes entreprises, certains laboratoires scientifiques et administrations gouvernementales de pays riches en possèdent. L’industrie informatique est alors dominée par les fabricants de matériels, IBM au premier chef. Le logiciel est considéré comme un service sur mesure offert aux clients et les machines des différents constructeurs ne sont pas compatibles. Moins d’un pourcent de l’humanité se trouve directement en contact avec les ordinateurs. Si l’on excepte quelques visionnaires6, jusqu’au milieu des années 1970, personne ne les considère comme des médias de communication.

4. L’Internet

A partir des années 1970, l’industrie électronique – Intel en tête – commence à fabriquer en masse des micro-processeurs qui regroupent plusieurs composants miniaturisés dans un seul boîtier, ce qui accélère considérablement les calculs, diminue les prix, allège les machines et ouvre la voie à l’informatique personnelle. Cette dernière devient à son tour la base de la nouvelle industrie du logiciel. Comme les ordinateurs personnels de différentes marques utilisent souvent les mêmes micro-processeurs, ils peuvent adopter des systèmes d’exploitation communs et faire tourner les mêmes logiciels. On découvre que les applications n’ont pas besoin d’être programmées sur mesure, mais que quelques applications-types peuvent être utilisées par tout le monde (traitement de texte, tableur, dessin industriel, etc.). L’étoile d’IBM décline et le couple Intel-Microsoft commence à dominer l’informatique. Les premiers ordinateurs personnels, au maniement plutôt ésotérique, étaient réservés aux initiés et aux passionnés. Le Mackintosh (1984) conçu par l’équipe de Steve Jobs chez Apple affiche des interfaces conviviales qui permettent à tout un chacun de s’approprier les nouvelles machines. La souris, les icônes, le multi-fenêtrage, les hypertextes – qui avaient été imaginées par Douglas Engelbart dès les années 1960 – vont bientôt habiller tous les ordinateurs. Le développement de l’informatique personnelle met entre les mains d’une élite de jeunes urbains éduqués des pays riches – autour d’un pourcent de la population mondiale – de puissants outils de production de messages, qu’il s’agisse de textes, de tableaux de chiffres, d’images ou de musique.

Seconde révolution des années 1970 : la télématique. Les télécommunications se numérisent et les ordinateurs communiquent. Les activités de la poste, de l’édition, de la presse et de la diffusion radio-télévisée se mettent à converger vers le numérique, qui commence à être perçu comme un vecteur de communication et non seulement comme un calculateur arithmétique. La démocratisation des imprimantes et le développement des réseaux de communication entre ordinateurs, tout comme l’ouverture des ondes hertziennes et la multiplication des chaines de radio et de télévision, commencent à remettre en question les monopoles sur la diffusion massive des messages, qui appartenaient traditionnellement aux éditeurs, journalistes professionnels et responsables des grands réseaux de télévision7. Entre 1950 et 1970, il est rare que des flux de données circulent entre les machines. La tendance à la connexion se manifeste dès le milieu des années 1970 et devient la norme pendant les années 1980. Pour adresser les ordinateurs dans les réseaux de télécommunication, le protocole de l’Internet (inventé en 1969 sur une commande de l’armée américaine) s’impose alors face à ses nombreux concurrents grâce à son architecture décentralisée et sa facilité d’utilisation. On peut considérer n’importe quel processeur de données – aussi complexe soit-il – comme une « boîte noire » faisant office de macro-opérateur. C’est ainsi que le protocole de l’Internet, en adressant les ordinateurs dans le réseau, a du même coup ouvert un système universel d’adressage des opérateurs, une sorte de super-processeur distribué. Au stade de l’Internet et de l’informatique personnelle, les ordinateurs ont désormais une adresse dans le réseau mondial. En conséquence, ils peuvent « collaborer » et l’éventail des types de traitement et d’applications s’élargit considérablement. Les ordinateurs sont devenus des outils de communication, mais ils ne sont encore utilisés que par une fraction minime de la population mondiale.

6. Le cerveau global

6.1 Mégadonnées et mégamachines

Les taux de connexions continuent à croître et pointent vers quatre-vingt-dix pour cent de l’humanité avant la moitié du XXIe siècle. Le médium algorithmique devient la sphère publique dominante tandis que les médias classiques (imprimerie, téléphone, disque, radio, télévision) se fondent progressivement dans le décor numérique. Vente en gros ou au détail, marchés de seconde main, transport urbain, hôtellerie, immobilier… secteur après secteur économique, les structures pré-numériques se dissolvent au profit de nouvelles formes de coordination des activités basées sur des applications mobiles supportées par le cloud. L’éducation, la santé et la politique se transigent de plus en plus dans les médias sociaux. Des flots de données montent des objets intelligents et des environnements connectés. Les échantillons et collections limités des premiers temps de l’informatique font place au recueil de toutes les informations disponibles. Au lieu des petits stocks de données au format homogène qui étaient soigneusement codés et entreposés dans les ordinateurs d’antan, il faut maintenant traiter les torrents hétérogènes d’information produits en temps réel par les employés, les clients, les partenaires, les marchés, les villes, les territoires… Pour traiter ces mégadonnées (big data), les outils et les méthodes de calcul des périodes antérieures ne sont plus pertinents. De nouvelles applications se spécialisent dans le traitement statistique à grande échelle et la visualisation des patterns et tendances. Afin de canaliser les mégadonnées et d’exécuter les algorithmes qui les exploitent, les grandes compagnies du cloud construisent des mégamachines virtuelles qui relient en grappes leurs centres de calcul. Autre signe des temps, en 2017 Apple, Google, Amazon, Facebook et Microsoft avaient dépassé en capitalisation boursière les autres multinationales, y compris les pétrolières.

6.2 L’intelligence artificielle

Au cours de la seconde moitié du XXe siècle, des chercheurs avaient conçu des algorithmes d’intelligence artificielle capables de simuler des apprentissages à partir de modèles imitant le comportement des réseaux de neurones. Mais des temps de calcul prohibitifs avaient découragé les applications pratiques. Or de nouvelles générations de puces électroniques, parmi lesquelles se distinguent les GPU (Graphics Processing Units ou unités de traitement graphique) ont remis à l’ordre du jour l’apprentissage des machines par simulation neuromimétique (deep learning). Connectés par milliers dans les mégamachines, les nouveaux processeurs exécutent désormais des programmes d’intelligence artificielle sur des déluges de mégadonnées. En 2017, les grandes compagnies du Cloud offrent des cours en ligne pour enseigner le deep learning parce que les universités ne suffisent pas à fournir à la demande de compétences. Elles mettent aussi en libre accès nombre de composants de leurs programmes d’intelligence artificielle afin de favoriser la création d’écosystèmes de services et d’applications autour de leurs centres de calculs. La plupart des gadgets et des applications utilisent désormais l’apprentissage automatique, détectent des patterns statistiques, traitent les langues naturelles8, reconnaissent des formes visuelles ou sonores. Les systèmes de recommandation d’Amazon, Spotify ou Netflix9 apprennent nos préférences littéraires, musicales ou cinématographiques de nos comportements. Le système de reconnaissance visuelle de Pinterest affiche les images qui ressemblent le plus à celle que nous venons de sélectionner. L’algorithme de Facebook détermine notre fil de lecture en fonction de nos « like ». Nos banques repèrent les anomalies qui révèlent un vol de carte de crédit. L’intelligence artificielle contribue de plus en plus à l’infrastructure du monde physique : elle traite des données environnementales, équipe les robots et les véhicules autonomes, optimise le trafic et les dépenses d’énergie des villes connectées.

Pour éviter les fantasmes apocalyptiques, il faut s’entendre sur la notion d’apprentissage des machines. Les ordinateurs n’apprennent pas de manière autonome. Les programmes de la nouvelle intelligence artificielle sont produits par un couple. D’un côté, un algorithme d’apprentissage simule un système complexe de type neuronal, sociobiologique ou physique. D’un autre côté, un ensemble de données entraine cet algorithme. Le programme d’intelligence artificielle n’arrive à traiter automatiquement l’information qu’après avoir été entraîné sur des dizaines de milliers d’exemples de problèmes accompagnés de la « bonne réponse » ou de données correctement catégorisées. Aussi bien l’algorithme d’apprentissage que les données d’entraînement ont été déterminés par des êtres humains. Le programme qui résulte de l’entraînement n’invente donc rien : c’est un produit mécanique. Il est pourtant très utile, car on n’aurait pas pu l’écrire directement, sans passer par la phase d’entraînement sur des données. Les données d’entraînement sont en fait la partie variable du programme d’intelligence artificielle. Si ces données d’entraînement sont produites ou choisies par les utilisateurs, tout se passe comme si ces derniers contribuaient à programmer leur environnement de communication, de travail ou de jeu… comme s’ils dressaient des robots à leur service.

Nos gestes, communications et transactions sculptent les neurones logiciels qui déterminent en retour les informations qui nous sont présentées. Nous en faisons tous les jours l’expérience sur Facebook, puisque c’est bien nous qui – par nos « j’aime », partages et autres actions – commandons l’algorithme qui sert notre fil. Il suffit de changer délibérément de comportement pendant quelques jours pour voir le fil se modifier. L’algorithme de Facebook n’a un effet de « bulle cognitive » que si nous agissons de manière irréfléchie. La bulle éclate dès que nous interagissons avec des sources d’information plus diverses. Il faut généraliser cette humble prise de conscience à tous les comportements qui génèrent des données et qui alimentent l’apprentissage des neurones artificiels dans les nuages. Des cerveaux mécaniques externes à notre système nerveux apprennent de nos habitudes. Ces circuits neuronaux artificiels vont-ils un jour s’intégrer en un cerveau global ? Et si la chose arrive, selon quel projet de civilisation, selon quelle éducation l’intelligence collective humaine consciente et réfléchie va-t-elle s’élever à la maîtrise du cortex électronique ?

Reconnaissons dès maintenant que nous avons franchi une nouvelle étape dans le long processus historique d’externalisation de la mémoire : les données ne sont plus seulement enregistrées pour être analysées et traitées par des programmes, elles modèlent désormais les programmes eux-mêmes. Notre mémoire biologique ne se réduit pas à un simple enregistrement, à des données qu’on écrit et qu’on efface. Elle implique depuis toujours un apprentissage, l’acquisition d’habitudes, une évolution des manières de faire. Voici que la mémoire mécanique ressemble de plus en plus – et prolonge de mieux en mieux – la mémoire vivante.

6.3 Les registres infalsifiables des chaînes de blocs

Une autre innovation technique, celle de la Blockchain (« chaîne de blocs » en français) contribue à faire évoluer la mémoire numérique. La chaîne de blocs répond à un problème qui s’est posé avec de plus en plus d’acuité avec le développement du Web décentralisé et des applications pair-à-pair (P2P) : comment synchroniser une base de données distribuée dans laquelle une multitude d’utilisateurs peuvent lire et écrire librement ? Pour résoudre ce problème de manière sûre sans faire intervenir une autorité centrale transcendante, il faut établir automatiquement un consensus entre les utilisateurs sur l’ordre et les dates exactes des transactions. Les protocoles et les algorithmes supportant le consensus distribué représentent désormais un vaste champ de recherche en informatique. La chaîne de blocs, majoritairement adoptée par l’industrie au moment où j’écris ces lignes, n’est que l’une des approches possibles.

Sans entrer dans les détails techniques, une chaîne de blocs est un registre numérique infalsifiable qui repose sur un système de cryptographie distribuée. Cette nouvelle génération de livres de comptes sert de fondement à des monnaies électroniques indépendantes des devises garanties par les états nations. Le Bitcoin est la plus connue de ces nouvelles monnaies. Mais les chaînes de blocs permettent aussi d’enregistrer de manière irréversible toutes sortes de transactions monétaires (achat, ventes, prêts, remboursements…) ou non monétaires, tels que consentements, votes, etc. Elles tracent les circulations de valeur, authentifient les actes sociaux, exécutent automatiquement les contrats aux dates d’échéances. De nombreuses applications sont envisagées dans la finance et l’industrie mais aussi dans l’éducation, la santé et même dans l’art. En garantissant l’enregistrement des actes de langages, la chaîne de blocs confère à la mémoire numérique une dimension pragmatique.

Les protocoles et algorithmes de consensus distribué libèrent les parties prenantes des intermédiaires humains qui étaient traditionnellement chargés d’authentifier les transactions. Or aussi bien les administrations publiques que celles des grandes entreprises privées tirent leur légitimité de l’immense service que rendent les « bureaux » depuis des siècles : garantir l’exactitude des informations essentielles sur les biens et les personnes, enregistrer les actes. Si les titres, contrats et transactions peuvent être authentifiés par le nouveau notaire artificiel, les bureaucraties publiques ou privées chargées d’enregistrer et de garantir les actes seront remises en question dans les décennies qui viennent. Et puisque, depuis ses origines, l’état a tenu les comptes de ses sujets, une mutation politique est à prévoir. Verra-t-on une alliance de grandes compagnies du Cloud ou quelqu’autre forme sociale coopérative fournir à tous les habitants de la planète un service public gratuit d’état civil10, de cadastre, d’authentification des propriétés, d’enregistrement de contrats, de comptabilité transparente, de dépôt légal et de certification de compétences ?

7. La sphère sémantique

Dans la figure 1, les niveaux de calcul automatique de plus en plus puissants sont représentés par des rectangles. Chaque niveau repose sur les niveaux « inférieurs » qui le précèdent par ordre d’émergence historique. Un niveau est donc conditionné par les niveaux inférieurs. Mais, inversement, chaque niveau additionnel confère aux niveaux inférieurs une détermination socio-technique supplémentaire, puisqu’il les fait servir à une nouvelle fin. Le médium algorithmique dispose déjà d’un système d’adressage universel des ordinateurs (l’Internet) et des données (le Web). Sur cette base, les centres de calcul des grandes compagnies de nuagique font proliférer les réseaux de neurones artificiels qui apprennent de nos comportements (le cerveau global). La prochaine étape, que j’appelle la sphère sémantique, sera probablement fondée sur de nouveaux progrès de l’intelligence artificielle (IA). Mais avant d’évoquer les progrès futurs il nous faut d’abord reconnaître les limites de l’IA contemporaine.

Les raisonnements humains réels sont émis par des corps vivants situés dans l’espace et emportés sur le fil d’un temps irréversible, ils sont orientés vers des fins et tirent leur pertinence d’un contexte d’interaction sociale. N’ayant à sa disposition que des outils logiques et statistiques, l’intelligence artificielle peine à rendre compte des horizons de conscience qui éclairent l’intelligence. Elle intègre mal dans ses modèles de la cognition la polysémie et les niveaux de complexité emboîtés des systèmes symboliques, sans même parler des tensions pragmatiques et des relations sociales qui animent la pensée et la communication humaine. A cet égard, nous vivons aujourd’hui dans une situation paradoxale puisque l’intelligence artificielle connaît un succès pratique impressionnant (voir le développement des formations et des demandes de spécialistes sur le marché) au moment même où ses limites théoriques deviennent évidentes.

Les algorithmes statistiques, l’apprentissage automatique, les réseaux neuronaux voire les simulations d’intelligence collective animale sont de plus en plus utilisés. Mais il faut bien constater que, malgré la multitude des outils algorithmiques disponibles, la réalité n’est pas toujours à la hauteur des annonces et l’IA ne peut toujours pas exhiber de modèle complet de la cognition. L’intelligence artificielle contemporaine se contente dans les faits de fournir une boîte à outils de plus en plus efficace et variée mais qui n’offre pas de solution générale au problème d’une modélisation mathématique de la cognition humaine. Sans trop l’avouer, la discipline a prudemment renoncé à simuler l’intelligence dans son intégralité. Pourtant, ne serait-il pas bien venu que l’informatique parvienne à intégrer dans ses algorithmes la finesse herméneutique et contextuelle11 auxquels les chercheurs en sciences humaines sont si attachés ? Et si la découverte de quelque système de coordonnées sémantique ouvrait la voie à un modèle unifié de l’intelligence, à une cosmologie scientifique des idées ?

Tous les animaux ont un système nerveux, mais seuls les humains ont accès au langage et à la conscience réflexive. C’est pourquoi le calcul neuronal ne simule que la cognition animale. Seul le calcul symbolique – sur la base du calcul neuronal – peut rendre compte de la cognition humaine et c’est donc celui-là qu’il faudra mathématiser tôt ou tard si l’on veut disposer d’un modèle de l’intelligence. Or le calcul symbolique ne se limite ni à l’arithmétique, ni aux statistiques, ni à la syntaxe : il comprend aussi la sémantique. Les algorithmes neuronaux traduisent et manipulent bel et bien des éléments de langage, mais ils le font comme des perroquets au gros cerveau mécanique, dressés à répéter les régularités perçues sans en comprendre les subtilités internes.

C’est pour surmonter les limites de l’IA contemporaine que j’ai inventé une langue à la sémantique calculable : IEML (le MétaLangage de l’Economie de l’Information). IEML n’a pas été conçu pour être parlé dans un environnement non technique mais plutôt pour être écrit, lu, traduit et exploré au moyen d’ordinateurs et de tablettes, avec un parseur et un dictionnaire multilingue au bout des doigts, peut-être avec un chatbot à portée de voix. Cette langue a six caractères de base: deux voyelles, trois consonnes et un silence. Les mots et les textes sont construits à partir de deux opérations algébriques sur ces éléments primitifs. Le dictionnaire contient un maximum de 10 000 mots (actuellement 3 500) incluant des noms, des verbes et des auxiliaires,12 tous lisibles à l’oeil nu par un humain. Les mots d’IEML ne sont aujourd’hui traduits qu’en français et en anglais mais le dictionnaire est prévu pour supporter autant de langues que l’on voudra. Au niveau paradigmatique, les relations entre les mots du dictionnaire sont explicites. Le sens de chaque mot est exactement défini par ses relations avec les autres mots et chaque mot se trouve au centre d’une unique étoile de relations avec les autres mots du dictionnaire. Le niveau syntagmatique empile des mots complexes, des phrases et des super-phrases. Les mots complexes ou topoï sont composés d’une racine et d’une flexion dont chacune peut contenir plusieurs mots simples. Une phrase s’écrit comme un arbre de relations entre topoï, les relations étant précisées par des auxiliaires de type : « sujet », « objet », « complément », etc. Le plus haut niveau de la hiérarchie grammaticale, le texte, est appelé USL (Uniform Semantic Locator) parce qu’il est utilisé comme une adresse distincte dans un système de coordonnées sémantique. Au niveau textuel, les anaphores grammaticales13 sont explicites et les isotopies14 sont calculées automatiquement.

La grammaire d’IEML est non-ambigüe et régulière, ce qui n’est pas le cas des capricieuses langues naturelles, comme le Français, l’Anglais, le Russe ou l’Arabe. C’est pourquoi un automate peut produire et reconnaître des phrases correctes en IEML. Il y a évidemment beaucoup d’autres langages réguliers dans le monde de l’informatique – principalement des langages de programmation – mais aucun d’eux n’est une langue complète. En particulier, les langages de programmation n’ont pas de dictionnaires indépendants des langues naturelles qui permettraient à ses « locuteurs » de comparer, par exemple, les mérites gastronomiques respectifs de la tarte aux fraises et de la tarte à la rhubarbe. IEML n’a pas seulement une syntaxe régulière et un dictionnaire couvrant toute l’étendue de l’expérience humaine. Il a aussi une sémantique non-ambigüe. Un algorithme est capable de « comprendre » une chaîne de caractères syntaxiquement correcte, c’est-à-dire de produire le réseau sémantique (paradigmatique, syntagmatique, textuel) unique correspondant à cette chaîne de caractères. Le réseau sémantique est lui-même traduit automatiquement dans les langues supportées par le dictionnaire. IEML ne comporte ni homophones, ni synonymes, ni amphibologies. Le principe général de l’univocité d’IEML est le suivant : les relations entre les signifiants de la langue peuvent être calculées automatiquement à cause de la nature algébrique de sa syntaxe et les relations entre les signifiés sont parallèles aux relations entre signifiants. En d’autres termes, l’univocité d’IEML est basée sur une isomorphie entre graphes de relations algébriques entre signifiants et graphes de relations sémantiques entre signifiés.

L’acte de langage standard en IEML est un post dans lequel le locuteur (qu’il s’agisse d’un humain ou d’un bot) catégorise un document ou un ensemble de données au moyen d’un USL jouant le rôle de métadonnée sémantique. Dans cette configuration, il ne peut y avoir d’ambiguïté pragmatique au sujet de la référence qui est, par construction, la donnée catégorisée par l’USL. J’ajoute que, quelle que soit la langue utilisée, une part importante de la signification pragmatique en ligne peut être calculée sur la base de l’impact social des messages et des connexions entre usagers. Néanmoins, puisqu’IEML est une langue complète qui peut être parlée librement par ses locuteurs, elle ne peut être débarrassée de toute ambiguïté pragmatique. Par exemple, rien ne vous empêche de mentir en IEML ou de catégoriser ironiquement comme bon ce que vous jugez mauvais. Même si le texte IEML est univoque, l’acte de langage reste indéterminé.

En somme, le réseau des relations et distances sémantiques entre expressions est compris d’office dans le code linguistique IEML. Etant donné un ensemble de textes en IEML, chacun d’eux calcule l’étoile de ses relations sémantiques avec les autres textes. Une fois les données catégorisées en IEML, ce sont les relations sémantiques et les similarités entre données qui peuvent être calculées. Des collections de données catégorisées en IEML peuvent être visualisées au moyen d’arbres, de cartes et de tableaux de bord sémantiques en 2D et même par des mondes virtuels immersifs en 3D. IEML ouvre la voie à la projection de quantités, de séries temporelles, de lieux géographiques et de réseaux sociaux sur un espace sémantique géométriquement cohérent.

Supposons qu’IEML, qui n’existe aujourd’hui qu’à l’état de prototype, parvienne au stade industriel. Sur un plan scientifique, cette langue – dont les symboles, signifiant et signifié, se manipulent comme un groupe de transformations – fait office de système de coordonnées d’un cosmos des idées. Sur un plan technique, elle joue le rôle du système universel d’adressage des concepts de la figure 1. Les données ont alors des adresses sur une grille qui calcule automatiquement leurs relations sémantiques. Cet univers d’information est indéfiniment explorable par des algorithmes ouverts et communs, qui favorisent les dialogues et les comparaisons. En fonction des théories et des orientations pratiques qui ont mené à leur catégorisation par les utilisateurs, les collections de données s’auto-organisent en écosystèmes d’idées. Le même ensemble de données s’explore différemment en fonction des sens qu’il a pour une multitude de communautés. Univers de pratiques et cultures s’échangent des concepts et des règles opératoires sans pour autant renoncer à leur singularité. Grâce à des interfaces immersives utilisant les images, les sons et les langues naturelles, nous parlons et comprenons intuitivement la langue de l’intelligence collective. Le couplage entre humains et robots se perfectionne. Des hologrammes visualisent des cascades de perspectives sémantiques. Entre mondes virtuels et réalités augmentées, la sphère sémantique procure une maîtrise sensori-motrice de l’univers informationnel.

Les capacités d’analyse, de synthèse et de prévision d’une société reposent ultimement sur la structure de sa mémoire, et notamment sur son système de codage et d’organisation des données. Pour que le médium algorithmique en cours de construction devienne la matrice d’une nouvelle épistémè – plus puissante que celle d’aujourd’hui, encore mal dégagée de l’ère typographique – il lui manque un système d’adressage universel des concepts qui soit à la hauteur de sa puissance de calcul. Alors le cerveau électronique global s’augmentera de circuits spécialisés qui lui donneront accès au sens de l’intérieur et non à travers l’enveloppe statistique d’un cerveau de perroquet. Coordonné par une langue calculable, décloisonné, il permettra à l’intelligence collective de mieux se réfléchir. Les collectivités observeront l’évolution et l’état présent de leurs activités cognitives. Elles appliqueront leurs nouvelles capacités d’analyse, de synthèse et de prévision à la gestion sociale de leurs connaissances et de leurs apprentissages. Les individus maîtriseront leurs chemins d’auto-formation en syntonie avec les groupes auxquelles ils participent. Chacun simulera les effets de croissance personnelle et de pollinisation croisée induits par sa circulation entre les communautés. Mémoire réflexive, intuition perspectiviste, communication interopérable et transparente ajouteront leurs effets pour produire une augmentation cognitive inouïe.

En ligne

Bases de données d’articles récents :

Bibliographie

Amdahl, Gene. 1964. « Architecture of the IBM System/360 ». IBM Journal.

Auroux, Sylvain. 1994. La révolution technologique de la grammatisation. Liège: Mardaga. http://catalog.hathitrust.org/api/volumes/oclc/33865105.html.

Austin, J. L. 1962. How to Do Things with Words. New York: Oxford University Press.

Bacry, H. 2000. La symétrie dans tous ses états. Paris: Vuibert.

Bardini, Thierry. 2000. Bootstrapping: Douglas Engelbart, Coevolution, and the Origins of Personal Computing. Stanford, Calif.: Stanford University Press.

Barthes, Roland. 1964. Essais critiques. Paris: Seuil.

Benveniste, Émile. 1958. « Catégories de pensée et catégories de langue ». Les Études philosophiques 13 (4):419‑29. http://www.jstor.org/stable/20842782.

Benveniste, Émile. 1966. Problèmes de linguistique générale. Paris: Gallimard.

Berners-Lee, Tim. 1996. « Univeral Resource Identifiers. Axioms of Web architecture ». WWW Consortium. https://www.w3.org/DesignIssues/Axioms.html#opaque.

Berners-Lee, Tim. 1999. Weaving the Web: the Original Design and Ultimate Destiny of the World Wide Web by Its Inventor. New York: Harper.

Bickerton, Derek. 1995. Language and Human Behavior. Seattle: University of Washington Press.

Boden, Margaret A. 2006. Mind as Machine: a History of Cognitive Science. Oxford: Clarendon Press.

Bonabeau, Eric, Marco Dorigo, et Guy Theraulaz. 1999. Swarm Intelligence: From Natural to Artificial Systems. Oxford University Press, New York, USA. http://hdl.handle.net/2013/ULB-DIPOT:oai:dipot.ulb.ac.be:2013/74515.

Borges, Jorge Luis. 1945. « El Aleph ». Sur, nᵒ 131 (septembre).

Borges, Jorge Luis. 1951a. « La bibliothèque de Babel ». In Fictions. Paris: Gallimard.

Borges, Jorge Luis. 1951b. « Le jardin aux sentiers qui bifurquent ». In Fictions. Paris: Gallimard.

Castells, Manuel. 2009. Communication Power. New York: Oxford University Press.

Changeux, Jean-Pierre. 1985. Neuronal Man: The Biology of Mind. New York: Pantheon Books.

Chomsky, Noam. 1957. Syntatic Structures. The Hague: Mouton & Co.

Chomsky, Noam. 2000. New horizons in the study of language and mind. Cambridge; New York: Cambridge University Press.

Chomsky, Noam, et Marcel P. Schützenberger. 1963. « The Algebraic Theory of Context Free Languages ». In Computer programming and formal systems, 118‑61. Amsterdam: North Holland Pub. co. http://books.google.com/books?id=gCI4AAAAMAAJ.

Danchin, Antoine, et Jean-Pierre Changeux. 1976. « Selective Stabilisation of Developing Synapses as a Mechanism for the Specification of Neuronal Networks ». Nature 264 (5588):705. https://doi.org/10.1038/264705a0.

Davis, Martin. 2000. Engines of Logic: Mathematicians and the Origin of the Computer. New York: W. W. Norton & Company.

Deacon, Terrence William. 1997. The Symbolic Species: The Co-Evolution of Language and the Brain. New York: W.W. Norton.

De Chardin, Pierre Teilhard. 1955. Le phénomène humain. Paris: Editions Du Seuil.

Deleuze, Gilles. 1969. Logique du sens. Paris: Editions de Minuit.

Deleuze, Gilles, et Félix Guattari. 1972. L’anti-Oedipe. Vol. 1. Capitalisme et schizophrénie. Paris: Éditions de Minuit.

Deleuze, Gilles, et Félix Guattari. 1980. Mille plateaux. Vol. 2. Capitalisme et schizophrénie. Paris: Éditions de Minuit.

Derrida, Jacques. 1967. De la grammatologie. Paris: Édtions de Minuit.

Descola, Philippe. 2005. Par-delà nature et culture. Paris: Gallimard.

Dreyfus, Hubert L. 1992. What Computers Still Can’t Do: A Critique of Artificial Reason. Cambridge MA: MIT Press.

Dupuy, Jean-Pierre. 2005. Aux origines des sciences cognitives. Paris: La Découverte.

Eco, Umberto. 1992. Le Signe: histoire et analyse d’un concept. Paris: Libraire Générale Française.

Edelman, Gerald M. 1987. Neural Darwinism: The Theory of Neural Group Selection. New York: Basic Books.

Eisenstein, Elizabeth L. 1983. The Printing Revolution in Early Modern Europe. Cambridge MA: Cambridge University Press.

Engelbart, Douglas. 1962. « Augmenting Human Intellect; a Conceptual Framework. » Menlo Park, Calif.: Stanford Research Institute.

Foucault, Michel. 1969. L’Archéologie du savoir. Paris: Gallimard.

Fourquet, François. 2007. « Critique de la raison cognitive ». In Le capitalisme cognitif: la nouvelle grande transformation, 265‑76. Paris: Éditions Amsterdam.

Frege, Gottlob. 1971. Écrits logiques et philosophiques. Traduit par Claude Imbert. Paris: Editions du Seuil. http://banq.pretnumerique.ca/accueil/isbn/9782021230253.

Ganascia, Jean-Gabriel. 2017. Le mythe de la singularité: faut-il craindre l’intelligence artificielle ?

Gardner, Howard. 1987. The Mind’s New Science: A History of the Cognitive Revolution. New York: Basic Books.

Goody, Jack. 1977. The Domestication of the Savage Mind. Cambridge: Cambridge University Press.

Goody, Jack. 1987. The Logic of Writing and the Organization of Society. Cambridge [Cambridgeshire]; New York: Cambridge University Press.

Granovetter, Mark S. 1973. « The Strength of Weak Ties ». American Journal of Sociology 78 (6):1360‑80. https://doi.org/10.1086/225469.

Grondin, Jean. 2017. L’herméneutique. Paris: Presses universitaires de France.

Guénard, François, Ecole normale supérieure (Paris), Séminaire de philosophie et mathématiques, René Thom, Jean Alexandre Dieudonné, Maurice Loi, et Gilbert Lelièvre. 1982. Penser les mathématiques. Points, 29. Paris: Editions du Seuil.

Hesse, Hermann. 2002. Le jeu des perles de verre. Traduit par Jacques Martin. Paris: Librairie Générale Française.

Hjelmslev, Louis. 1971. Essais linguistiques. Paris: Éditions de Minuit.

Hodges, Andrew, et Alan Mathison Turing. 1992. Alan Turing : The Enigma. London: Vintage.

Innis, Harold A. 1950. Empire and Communications. Oxford: Clarendon Press.

Jakobson, Roman. 1981. Essais de linguistique générale. Traduit par Nicolas Ruwet. Vol. 1-2. Paris: Minuit.

Kapetanios, Epaminondas. 2010. « On the Notion of Collective Intelligence: Opportunity or Challenge? » International Journal of Organizational and Collective Intelligence (IJOCI) 1 (1):1‑14. https://doi.org/10.4018/joci.2010100801.

Kapetanios, Epaminondas, et Georgia Koutrika. 2010. « Special Issue on Collective Intelligence ». Information Sciences, special issue on collective intelligence, Elsevier, 180 (janvier):1‑3. https://doi.org/10.1016/j.ins.2009.10.009.

Kerbrat-Orecchioni, Catherine. 2001. Les actes de langage dans le discours. Paris: Nathan.

Koyré, Alexandre. 1958. From the Closed World to the Infinite Universe. New York: Harper. http://books.google.com/books?id=Pa8NAQAAIAAJ.

Lakoff, George. 1987. Women, Fire, and Dangerous Things What Categories Reveal About the Mind. Chicago; London: The University of Chicago Press.

Langacker, Ronald Wayne. 1987. Foundations of Cognitive Grammar. Stanford: Stanford Univ. Press.

Leibniz, Gottfried Wilhelm. 1695. « Système nouveau de la nature et de la communication des substances ». Journal des savants, juin. https://fr.wikisource.org/wiki/Syst%C3%A8me_nouveau_de_la_nature?match=en.

Leibniz, Gottfried Wilhelm. 1764. Nouveaux Essais sur l’entendement humain. https://fr.wikisource.org/wiki/Nouveaux_Essais_sur_l%E2%80%99entendement_humain?match=en.

Leibniz, Gottfried Wilhelm. 1886. La monadologie: Nouv. éd., avec une introd., des sommaires, un commentaire perpétuel, extrait des autres ouvrages de Leibniz, des exercices et un lexique de la terminologie Leibnizienne. Paris: E. Belin. https://fr.wikisource.org/wiki/Monadologie_(%C3%89dition_Bertrand,_1886).

Leibniz, Gottfried Wilhelm. 2000. De l’horizon de la doctrine humaine. Paris: Lavoisier.

Levy-Leblond, Jean-Marc. 1998. « La nature prise à la lettre ». Alliage, nᵒˢ 37-38. http://www.tribunes.com/tribune/alliage/37-38/jmll.htm.

Lévy, Pierre. 1986a. « Analyse de contenu des travaux du Biological Computer Laboratory (BCL) ». Cahiers du CREA, nᵒ 8:155‑91.

Lévy, Pierre. 1986b. « L’Oeuvre de Warren McCulloch ». Cahiers du CREA, nᵒ 7:211‑55.

Lévy, Pierre. 1994. L’Intelligence collective: pour une anthropologie du cyberspace. Paris: Editions La Découverte.

Lévy, Pierre. 1995. Qu’est-ce que le virtuel? Paris: La Découverte.

Lévy, Pierre. 1997. Collective intelligence: mankind’s emerging world in cyberspace. Cambridge, Mass.: Perseus Books.

Lévy, Pierre. 1998. Becoming Virtual: Reality in the Digital Age. New York: Plenum Trade.

Lévy, Pierre. 2009. « Toward a Self-referential Collective Intelligence Some Philosophical Background of the IEML Research Program ». In Computational Collective Intelligence. Semantic Web, Social Networks and Multiagent Systems, édité par Nguyen Ngoc Than, Kowalczyk Ryszard, et Chen Shyi-Ming, 22‑35. Lecture Notes in Computer Science. Springer, Berlin, Heidelberg. https://doi.org/10.1007/978-3-642-04441-0_2.

Lévy, Pierre. 2011. La sphère sémantique. Computation, cognition, économie de l’information. Paris-Londres: Hermès-Lavoisier.

Licklider, Joseph. 1960. « Man-Computer Symbiosis ». IRE Transactions on Human Factors in Electronics HFE-1 (mars):4‑11. https://groups.csail.mit.edu/medg/people/psz/Licklider.html.

Llull, Ramón. 1990. Ars Magna. Traduit par Martı́nez GázqueJosé et Bejarano SánchezVergilio. Madrid: Editorial Patrimonio Nacional.

Logan, Robert K. 2007. The Extended Mind: The Emergence of Language, the Human Mind, and Culture. University of Toronto Press.

Marlowe, Christopher, et Sylvan Barnet. 1969. Doctor Faustus. New York: Penguin.

Martinet, André. 1960. Eléments de linguistique générale. Paris: A. Colin.

Maturana, Humberto R, Francisco J Varela, Robert Paolucci, et John Zachary Young. 1988. The Tree of Knowledge: The Biological Roots of Human Understanding. Boston; London: Shambhala.

McClelland, James L, David E Rumelhart, University of CaliforniaSan Diego, et PDP Research Group. 1986. Parallel Distributed Processing: Explorations in the Micro-Structure of Cognition. Vol. 2. Cambridge, Mass.; London: MIT Press.

McCulloch, Warren S., et Walter Pitts. 1943. « A Logical Calculus of the Ideas Immanent in Nervous Activity ». The bulletin of mathematical biophysics 5 (4):115‑33. https://doi.org/10.1007/BF02478259.

McCulloch, Warren Sturgis. 1965. Embodiments of Mind. Cambridge MA: M.I.T. Press.

McLuhan, Marshall. 1962. The Gutenberg Galaxy: The Making of Typographic Man. Toronto: University of Toronto Press. http://site.ebrary.com/id/10383481.

McLuhan, Marshall. 2003. Understanding Media: The Extensions of Man. Édité par W. Terrence Gordon. Corte Madera, CA: Gingko Press.

McLuhan, Marshall. 2005. The Classical Trivium: The Place of Thomas Nashe in the Learning of His Time. Édité par W. Terrence Gordon. Corte Madera, CA: Gingko Press.

Mel’cuk, Igor. 1997. « Vers une linguistique Sens-Texte ». Leçon inaugurale. Collège de France. http://webcache.googleusercontent.com/search?q=cache:8bh0SlfKwuEJ:olst.ling.umontreal.ca/pdf/MelcukColldeFr.pdf+&cd=1&hl=fr&ct=clnk&gl=ca.

Meunier, Jean-Guy. 2014. « Humanités numériques ou computationnelles : Enjeux herméneutiques ». Sens Public, décembre. http://www.sens-public.org/article1121.html.

Minsky, Marvin Lee. 1967. Computation : Finite and Infinite Machines. Englewood Cliffs, N.J.: Prentice-Hall.

Mirman, Ronald. 1995. Group Theory, an Intuitive Approach. Singapore: London.

Nelson, Theodor H. 1981. Literary Machines. Swarthmore PA: Ted Nelson.

Neumann, John von. 1945. « First Draft of a Report on the EDVAC ». United States Army Ordnance Department and the University of Pennsylvania Moore School of Electrical Engineering W-670-ORD-4926. http://archive.org/details/vnedvac.

Neumann, J. Von. 1946. « The Principles of Large-Scale Computing Machines ». Annals of the History of Computing 3 (3):263‑73. https://doi.org/10.1109/MAHC.1981.10025.

Ong, Walter Jackson. 1982. Orality and Literacy: The Technologizing of the Word. London; New York: Methuen.

Otlet, Paul. 1934. Traité de documentation: Le livre sur le livre : Théorie et pratique. Bruxelles: Mundaneum.

Otlet, Paul. 1935. Monde, essai d’universalisme: connaissance du monde, sentiment du monde, action organisée et plan du monde. Bruxelles: Mundaneum.

Pask, Gordon. 1969. « The Architectural relevance of cybernetics ». Architectural Design.

Peruzzi, Alberto. 2006. « The Meaning of Category Theory for 21st Century Philosophy ». Axiomathes 16 (4):424‑59. https://doi.org/10.1007/s10516-005-0466-8.

Poincaré, Henri. 1905. La valeur de la science. Paris: Flammarion.

Poincaré, Henri. 1918. La science et l’hypothèse. Paris: Flammarion: 1902.

Poincaré, Henri. 1947. Science et méthode. Paris: Flammarion.

Project, Peirce Edition. 1998. The Essential Peirce: Selected Philosophical Writings (1893-1913). Bloomington, IN: Indiana University Press. http://public.eblib.com/choice/publicfullrecord.aspx?p=923144.

Randell, Brian. 1982. The Origins of Digital Computers - Selected Papers. Berlin-Heidelberg: Springer-Verlag. //www.springer.com/us/book/9783540113195.

Rastier, François. 1987. Sémantique interprétative. Paris: Presses universitaires de France.

Rastier, François. 1990. « La triade sémiotique, le trivium et la sémantique linguistique ». Nouveaux Actes Sémiotiques, nᵒ 9. http://epublications.unilim.fr/revues/as/1640.

Rastier, François. 2005. « Herméneutique et linguistique : dépasser la méconnaissance ». Texto X (4). http://www.revue-texto.net/Dialogues/Debat_Hermeneutique/Rastier_Herm-et-ling.html.

Russell, Stuart J, et Peter Norvig. 2010. Artificial Intelligence: A Modern Approach. Upper Saddle River: Prentice-Hall.

Sapir, Edward. 2004. Language, an Introduction to the Study of Speech. Mineola NY: Dover publications.

Saussure, Ferdinand de. 1916. Cours de linguistique générale. Lausanne: Payot.

Searle, John R. 1969. Speech Acts. an Essay in the Philosophy of Language. Cambridge University Press: Cambridge.

Searle, John R. 1983. Intentionality: An Essay in the Philosophy of Mind. Cambridge: Cambridge University Press.

Serres, Michel. 1968. Le Système de Leibniz et ses modèles mathématiques. Paris: Presses universitaires de France.

Serres, Michel. 1989. Eléments d’histoire des sciences. Édité par Michel Serres. Paris: Bordas.

Shannon, Claude E, et Warren Weaver. 1949. The Mathematical Theory of Communication. Urbana: University of Illinois.

Simondon, Gilbert. 1958. Du mode d’existence des objets techniques. Paris: Aubier-Montaigne.

Stengers, Isabelle. 1993. L’invention des sciences modernes. Paris: La Découverte.

Stephens, Tonya Hongsermeier, Ivan Herman. s. d. « The Semantic Web in Action ». Scientific American, 90‑97. Consulté le 25 novembre 2017. https://www.scientificamerican.com/article/semantic-web-in-actio/.

Turing, Alan Mathison. 1950. « Computing Machinery and Intelligence ». Mind, nᵒ 49:433‑60. http://cogprints.org/499/1/turing.HTML.

Turing, A. M. 1937. « On Computable Numbers, with an Application to the Entscheidungsproblem ». Proceedings of the London Mathematical Society s2-42 (1):230‑65. https://doi.org/10.1112/plms/s2-42.1.230.

Varela, Francisco J, Evan Thompson, et Eleanor Rosch. 1991. The Embodied Mind: Cognitive Science and Human Experience. Cambridge [Mass.: MIT Press.

Von Neumann, John, et Arthur W Burks. 1981. Theory of Self-Reproducing Automata. Urbana: University of Illinois Press.

Von Neumann, John, et Yale University Press. 1958. The Computer and the Brain. New Haven: Yale University Press.

Vygotskij, Lev Semenovič. 1986. Thought and Language. Édité par Alex Kozulin. Cambridge, MA: The MIT Press.

Weizenbaum, Joseph. 1976. Computer Power and Human Reason: From Judgment to Calculation. San Francisco: W.H. Freeman.

Whorf, Benjamin Lee. 1956. Language, Thought, and Reality: Selected Writings of B.l. Whorf. Édité par John Bissell Carroll. Cambridge MA: MIT Press.

Wiener, Norbert. 1950. The Human Use of Human Beings: Cybernetics and Society. NY: Doubleday.

Winograd, Terry, et Fernando Flores. 1986. Understanding Computers and Cognition: A New Foundation for Design. Norwood NJ: Ablex.

Wittgenstein, Ludwig. 1961. Tractatus Logico Philosophicus. London; New York: Routledge ; Humanities.

Wittgenstein, Ludwig. 1997. Philosophical Investigations. Oxford: Blackwell.

L’historien des sciences Alexandre Koyré fut l’élève de Hilbert à Gottingen… comme il fut celui de Husserl et de Bergson à Paris.↩

Je dois également citer ici les travaux du mathématicien, physicien et philosophe français Henri Poincaré dont les trois ouvrages La Science et l’Hypothèse (Flammarion, 1902) La Valeur de la Science Flammarion, 1905) et Science et Méthode (Flammarion, 1908), m’ont fortement inspiré. Il déclare dans une de ses lettres « Les mathématiques ne sont qu’une histoire de groupe. » Voir l’excellente conférence d’Etienne Ghys, disponible en ligne.↩

Certes, il y a plusieurs couches de codage entre la parole, l’écriture, le système de numération ordinaire et le code binaire. Il reste que les ordinateurs – et la machine de Turing qui en est le prototype abstrait – manipulent bel et bien des symboles. En plus d’avoir une réalité physique, les zéros et les uns sont aussi des signifiants… qui ne représentent évidemment des signifiés que pour les humains.↩

Considérons un ensemble de transformations sur des variables. Si ces opérations peuvent se composer et s’inverser, alors cet ensemble de transformations possède une structure de groupe. Par exemple, les opérations de translation, de rotation et de symétrie en miroir sur des solides dans l’espace euclidien peuvent se composer et s’inverser. Un autre exemple classique est celui des opérations de multiplication et d’addition sur les nombres rationnels.↩

J’ai décrit la naissance de la cybernétique au milieu du XXe siècle aux Etats-Unis et le développement concomitant des sciences et techniques de l’information dans le chapitre 2 de La Sphère sémantique (Lévy 2011). On se reportera également à mon article sur « L’invention de l’ordinateur » dans les Eléments d’Histoire des sciences, dirigé par Michel Serres (1989).↩

Comme Joseph Licklider (1915-1990), Douglas Engelbart (1925-2013) ou Ted Nelson (1937- …).↩

Un monopole d’ailleurs bien souvent régulé ou contrôlé par les gouvernements.↩

Le traitement automatique du langage naturel n’a jamais été aussi efficace et populaire. Qui ne connaît pas Google Translate ?↩

Notons que les systèmes de recommandation existaient dès les années 2000.↩

A titre d’illustration, Facebook s’est positionnée très tôt (sans succès pour le moment) auprès des états comme potentielle instance de certification d’identité.↩

En IEML, les auxiliaires comprennent les adjectifs, adverbes, prépositions, cas, conjugaisons, pronoms, etc.↩

L’anaphore relie des pronoms ou des conjonctions aux mots ou aux phrases dont ils tiennent lieu. Par exemple, quand nous lisons un pronom, nous savons à quel nom – mentionné dans la phrase qui précède ou qui suit – il réfère.↩

Les isotopies sont les thèmes ou unités de sens récurrentes qui tissent l’unité d’un texte.↩